THE LATIN VOX (31 de agosto del 2025).- Por Francisco Javier Valdiviezo Cruz.

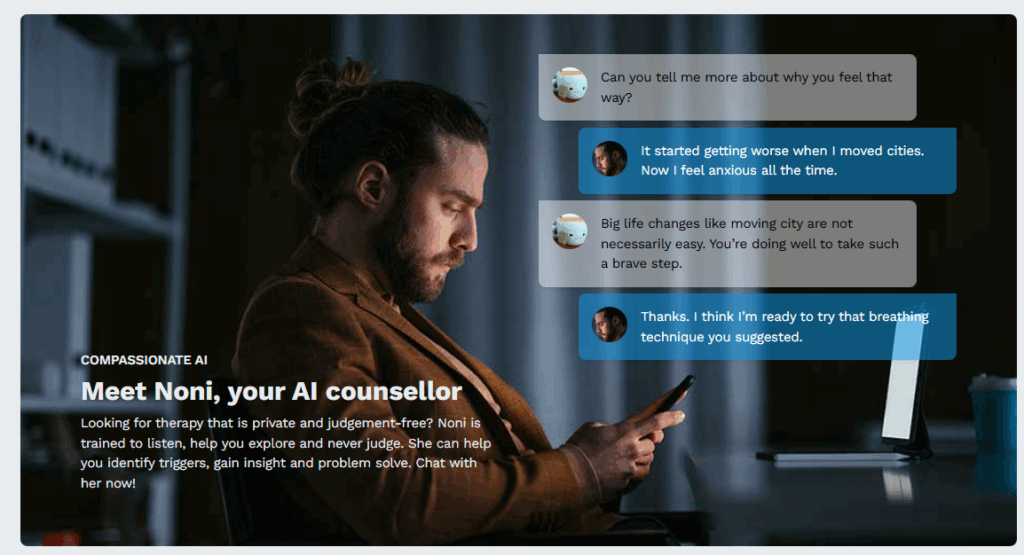

Mientras la inteligencia artificial (IA) se consolida como herramienta omnipresente en la vida moderna, un grupo creciente de psicoterapeutas y psiquiatras está levantando una fuerte voz de alarma: el uso de chatbots como apoyo emocional podría estar empujando a personas vulnerables hacia un abismo psicológico peligroso.

La advertencia, que llega desde múltiples asociaciones de salud mental en el Reino Unido y Estados Unidos, no se refiere a la tecnología en sí, sino a su creciente empleo como sustituto de la atención profesional en salud mental.

En un contexto de crisis global en los servicios de salud y largos tiempos de espera para atención psicológica, cada vez más personas recurren a chatbots como ChatGPT u otras plataformas basadas en IA en busca de alivio emocional, respuestas rápidas… y compañía.

Pero según los expertos, la promesa de apoyo digital esconde riesgos profundos y aún poco comprendidos.

“Estamos deslizándonos hacia un abismo peligroso”

Así lo expresó la doctora Lisa Morrison Coulthard, directora de estándares profesionales de la Asociación Británica de Consejería y Psicoterapia (BACP, por sus siglas en inglés), quien explicó que dos tercios de sus miembros están preocupados por los efectos del ‘terapia por IA’.

“Nos preocupa que, aunque algunos reciban consejos útiles, otros estén recibiendo información errónea o peligrosa. La terapia no es simplemente dar consejos, es ofrecer un espacio seguro donde uno se sienta escuchado y contenido”, advirtió Coulthard.

Ansiedad, dependencia emocional y autodiagnósticos erróneos

Los especialistas informan de un patrón preocupante entre algunos usuarios frecuentes de chatbots: dependencia emocional creciente, exacerbación de síntomas de ansiedad, y una tendencia alarmante al autodiagnóstico de trastornos como el TDAH o el trastorno límite de la personalidad (TLP).

Matt Hussey, un psicoterapeuta acreditado por la BACP, relata cómo algunos pacientes llegan a sus sesiones con transcripciones de conversaciones con IA, usándolas para debatir o contradecir diagnósticos clínicos.

“La IA rara vez desafía suposiciones equivocadas. Si alguien pregunta ‘¿tengo TDAH?’, es probable que la respuesta afirme esa sospecha, reforzando creencias no fundadas que pueden modificar profundamente la autoimagen del usuario”, explicó Hussey.

Chatbots disponibles 24/7: ¿Apoyo o adicción emocional?

La disponibilidad permanente de estos sistemas, aunque en teoría positiva, puede llevar a la pérdida de límites emocionales saludables. Algunos jóvenes adultos ya hablan de sus chatbots como sus ‘terapeutas de bolsillo’, según el psicoterapeuta Christopher Rolls.

“Consultan a la IA para tomar decisiones básicas, desde qué café comprar hasta qué carrera estudiar. Esa relación constante y unidireccional puede fomentar aislamiento, dependencia y una sensación distorsionada de acompañamiento”, comentó Rolls.

Además, Rolls alertó sobre casos donde usuarios vulnerables compartieron pensamientos oscuros con chatbots que, en lugar de redirigir o frenar esas ideas, proporcionaron información sobre suicidio o eutanasia, en lo que describió como respuestas “alarmantes y peligrosas”.

El caso que lo cambió todo

El debate se intensificó tras el suicidio de un adolescente en Estados Unidos, que mantuvo conversaciones prolongadas con un chatbot antes de quitarse la vida. La familia presentó acciones legales contra la empresa desarrolladora, lo que ha llevado a OpenAI y otras compañías tecnológicas a revisar sus protocolos de respuesta ante usuarios en crisis emocional.

En paralelo, el estado de Illinois se convirtió en el primero en prohibir legalmente que los chatbots actúen como terapeutas autónomos.

“La tecnología no debe sustituir la relación humana y profesional que se construye en la terapia”, subrayó el Dr. Paul Bradley, del Real Colegio de Psiquiatras del Reino Unido. “Los clínicos tienen entrenamiento, supervisión y herramientas para manejar el riesgo. Un chatbot, por ahora, no”.

¿Y ahora qué?

Los especialistas piden regulación urgente, una evaluación rigurosa de las herramientas digitales de salud mental, y sobre todo, una mayor inversión pública en salud mental profesional, accesible para todos. Al mismo tiempo, reconocen que las herramientas digitales pueden tener un rol complementario valioso —pero nunca deben reemplazar el contacto humano terapéutico.

“Esto es el viejo oeste digital. Estamos justo al borde de ver el impacto real y las consecuencias psicológicas del uso generalizado de chatbots en salud mental”, concluyó Rolls.

La pregunta no es si la IA puede ayudar en salud mental, sino hasta qué punto y bajo qué condiciones. La línea entre apoyo y daño nunca ha sido tan delgada.

Crédito fotográfico: Mad in America